AWS正努力將機器學習運維(MLOps)和應用程式開發運維(DevOps)融合

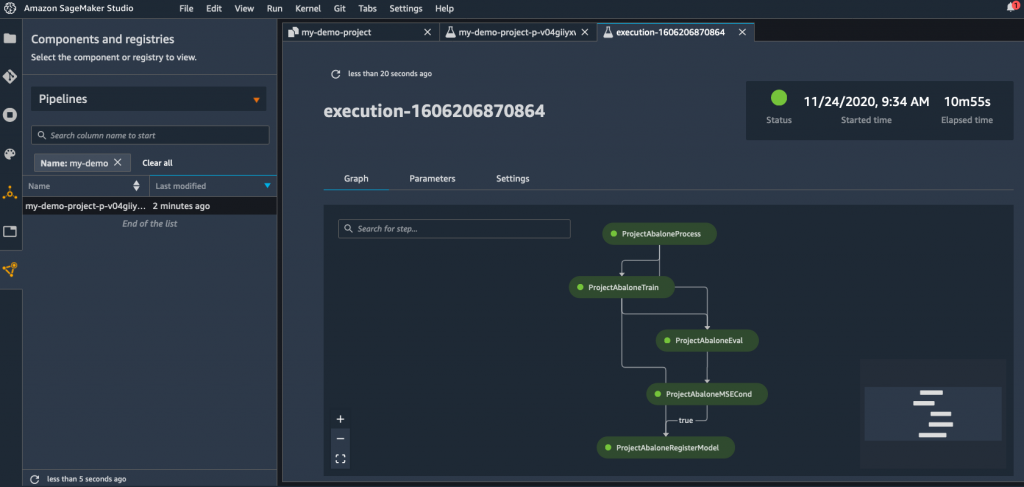

機器學習作業(MLOps)同雲端開發作業(DevOps)最佳實務交會的步伐,佇2021年會加速起飛。Amazon Web Services (AWS)最近舉辦的線上re:Invent大會,宣佈它會為Amazon SageMaker增添一大堆新功能,Amazon SageMaker是一款受管理的MLOps服務,新增的功能包括一款為MLOps所設計的持續整合/持續交付(CI/CD)服務,稱為Amazon SageMaker Pipelines。

Amazon SageMaker Pipelines讓開發者能定義一條機器學習工作流程,包羅萬象,從載入資料到訓練設定、演算法設置以及除錯演算法應有盡有。AWS主張,不用再另外取得並部署獨立的CI/CD平台來建置人工智慧(AI)模型,開發者可以利用AWS已提供的Amazon SageMaker Studio工具,在受管理的服務內管理工作流程來建置AI模型。

工作流程可以在團隊之間共享和重複使用,不論是要重現一個模型,或是當成起點來創建另一個AI模型。

Amazon SageMaker Pipelines也會將每個事件記錄在Amazon SageMaker Experiments,讓IT團隊能夠組織和追蹤機器學習實驗以及AI模型的版本。此外,Deep Profiling for Amazon SageMaker Debugger新功能,讓開發者能更快速地訓練AI模型,透過自動監控系統資源使用情況,一旦偵測到瓶頸就會發出警示。

AWS也為Amazon SageMaker新增了分散式訓練(Distributed Training)功能,它聲稱能讓開發者在AWS雲端服務上進行資料和AI並行處理,使訓練大型複雜的深度學習模型的速度比現有方法快上一倍。

這家雲端服務供應商還新增了Amazon SageMaker Edge Manager服務,讓開發者能最佳化、保護、監控和維護部署在邊緣運算裝置車隊上的機器學習模型。Amazon SageMaker JumpStart服務則讓開發者能搜尋AI模型、演算法和範例筆記本。

最後,AWS也新增了更多資料準備工具,預先配置支援AWS和第三方資料來源、儲存AI模型的儲存庫、預覽可自動將AI模型與資料來源(如Amazon RedShift資料湖)相匹配的額外工具、能將AI模型與圖形資料庫相匹配的功能,以及一款能在AI模型內偵測偏差的工具。

AWS機器學習服務的副總裁兼總經理Bratin Saha表示,隨著AI模型的使用量增加,這類計畫的範疇自然更適合雲端平台。許多應用程式開始同時運用多種類別的AI模型,Saha指出,這需要大量的資料和運算資源來訓練這些模型,而這些資源只有在雲端才能輕易取得。

AWS宣稱,目前已有超過10萬個客戶在其平台上使用各種工具和處理器類別來建置AI應用程式。AWS表示,2021年將推出基於AMD處理器的G4ad圖形處理器(GPU)實例,並透露明年將自行打造GPU。該公司也計劃新增一款基於Intel Habana GAUDI加速器最多8個的Amazon EC2實例,可提供比目前GPU型實例高達40%的價格/效能表現。

與此同時,AWS也延伸與NVIDIA的聯盟,在AWS Marketplace提供建置AI模型的軟體模組。

Saha表示,AWS實際上是邀請IT團隊在其平台上建置AI模型,或將自有的AI模型裝箱帶來。

AWS明顯是想主宰AI,無關這些功能如何注入企業應用程式。事實上,在許多情況下,AWS將自動為客戶建構AI模型,或透過應用程式介面(API)簡單傳回AI模型產生的結果。每個組織都必須自行決定,建置自有AI模型在何時最有意義,以及要多大程度依賴AWS來自動化部署流程。

可以確定的是,許多在AI模型問世之前就存在的DevOps原則,在持續更新使用這些模型的應用程式的這些年裡,仍將適用。